AI四类技术风险惊人 全球再拉警报(图)

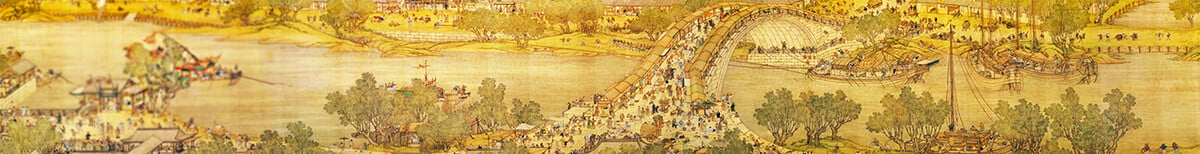

AI的飞跃式发展令我们感到世界并“不正常”。(图片来源: Adobe stock)

【看中国2023年6月30日讯】(看中国记者程帆编译综合报导)人工智能(AI)“不可思议”的发展速度,令科技专家、亿万富翁和普通人都表示担心,其未来可能将失控并给人类带来毁灭性灾难。

近日,美国非营利组织人工智能安全中心(CAIS)发表了一篇关于“灭绝式AI风险”的文章并指出,历史的前进并非一成不变,今天出现了一种前所未有的AI革命“加速发展”模式。这种飞跃式速度令我们感到世界并“不正常”。

CAIS主任亨德里克斯(Dan hendricks)进一步表述,如果能安全开发和监管AI技术,它将造福世界。然而与AI巨大的进步相比,人类尚未解决诸多的基本安全问题。他将这种“强大技术”的风险划分为4个类别,即恶意使用、武器化、欺骗性AI和组织风险。

例如,AI模型很容易会被不法份子训练用于恶意目的,制造生物武器。根据最新研究,用现有人工智能技术进行的试验,仅在6小时内就识别出了4万种此类生物武器化学物质。

这就意味着,尽管它在发现并改善健康的化学组合和药物化合物方面具有强大能力,而且比人类快很多,但也可以用来制造潜在的致命物质。

此外,AI自动化网络攻击甚至可以控制核发射井。根据CAIS的研究,如果一个国家投资在武器化AI系统,这个国家的军备可能会迅速升级,并引发一场“大规模战争”。那么,其他国家也就会更有动力这样做。

亨德里克斯表示,人工智能不应该被用于军备竞赛。他打比方称,“想像一群人站在薄冰覆盖的海面上。当他们远眺看到了对面遥远海岸的金银财宝,有些人可能会想冲刺。但他们必须冒着破冰、跳到冰冷海水的风险。在这种情况下,即使是最自私的人也应该谨慎行事。”

不仅如此,研究人员还写道,“AI可能会将某些隐秘信息意外泄露给公众或被恶意行为者窃取。”因为有些机构可能没办法投资于安全研究、缺乏对人工智能安全性的了解,或者阻止风险的发生。

他们将人工智能潜在的组织泄漏与历史上的灾难进行了比较,例如切尔诺贝利、三哩岛和挑战者号航天飞机致命事故等。

除此之外,人们还可以通过AI行骗,来获得社会的普遍认可。亨德里克斯引用了大众汽车的例子,该公司曾声称自己的汽车是低碳排放、高性能。可实际上,他们在车里设计了一项编程功能,该功能可以使发动机只在被监控时减少排放。

CAIS呼吁专门建立AI研究领域,推动制定安全标准,来预防可能给社会带来的大规模灾难。

对于该机构的声明,英国现任首相苏纳克首先在个人社交平台上转发并表示,英国政府正在非常仔细地研究这一问题。他还透露,已经向各大企业重申了“设置防护”措施的必要性,以确保AI开发可靠。

据路透社的报导,欧盟委员会副主席乔罗娃(Vera Jourova)本月初公开提出,对抗虚假信息。她要求谷歌、微软、Meta、TikTok等几十家科企,检测文本、图片及视频,并明显标记所有AI生成的内容。

来源:看中国

短网址: 版权所有,任何形式转载需本站授权许可。 严禁建立镜像网站.

【诚征荣誉会员】溪流能够汇成大海,小善可以成就大爱。我们向全球华人诚意征集万名荣誉会员:每位荣誉会员每年只需支付一份订阅费用,成为《看中国》网站的荣誉会员,就可以助力我们突破审查与封锁,向至少10000位中国大陆同胞奉上独立真实的关键资讯,在危难时刻向他们发出预警,救他们于大瘟疫与其它社会危难之中。

看完这篇文章您觉得

- 【贯明专栏】台湾最美的海湾 人间仙境七星潭(视频)

- 水果皇后——草莓(组图)

- 战火无情 造化弄人 那一代人的离合沧桑(组图)

- 千年前的人类抵御矮人“他”化为恶龙(图)

- 龙年龙抬头地龙翻身 世界已现动荡不祥之兆(组图)

- 世界上最贵的歌 4句歌词火遍全球(组图)

- 习公主真容终于曝光?网友:长得像习近平(组图)

- 瓦格纳兵变震惊习近平?传火箭军司令李玉超被抓(图)

- “结束一党专政才能令中华民族兴旺”咏春拳师涉反共言论被捕(组图)

- 传北京25000网警监控民众手机 警察抱怨(图)

- 北京最大恐惧发生了 日经:中国特使访乌就已忧普京不稳(图)

- 9大警讯!你的手机可能被“监听”了(图)

- “色字头上一把刀” 后半句更可怕(组图)

- 前团中央第一书记秦宜智屡遭贬职 原因复杂(图)

- 中共肺炎(又称武汉肺炎)

- 拜登

- 病毒

- COVID-19

- 疫苗

- 川普

- 特朗普

- 国安法

- 贸易战

- 习近平

- 华为

- 台铁

- 三峡大坝

- 新疆棉

- 长江

- 洪水

- 袁弓夷

- 港版国安法

- 汉光演习

- 国民党

- 退党

- 弗洛伊德

- BLM

- 中共

- 阎丽梦

- 金正恩

- 王岐山

- 赖清德

- 孟晚舟

- 关税

- 边境墙

- 彭斯

- 美国

- 贸易谈判

- 刘鹤

- 王沪宁

- 江泽民

- 崔永元

- 中南海

- 内幕

- 中共

- 反送中

- 贪官

- 情妇

- 腐败

- 反腐

- 打虎

- 官场

- 看中国

- 一国两制

- 法广

- 社交媒体

- 往事微痕

- 出卖国土

- FB

- 六四

- 朝鲜

- 加拿大

- 脱欧

- 央行

- 债务

- 杠杆

- 美元

- 货币

- 人民币

- 欧元

- 日元

- 港币

- 房地产

- 楼市

- 财政

- 财富

- 中产

- 海参崴

- 台湾

- 蔡英文

- 北京

- 刘强东

- 大妈

- 房价

- 疫苗

- 非洲猪瘟

- 大陆

- P2P

- 雾霾

- 基因编辑

- 防火墙

- 维权

- 709律师

- 上访

- 法轮功

- 网络审查

- 活摘器官

- 江东六十四屯

- 唐努乌梁海

- 长白山

- 白龙尾岛

- 江心坡

- SARS

- 新疆劳改营

- 言论自由

- 女主播

- 央视

- 华人

- 移民

- 华人

- 留学

- 海关

- 遣返

- 签证

- 回国

- 入籍

- 绿卡

- 民生

- 海外

- 加拿大

- 澳洲

- 民国

- 桂军

- 抗战

- 孙中山

- 蒋介石

- 宋美龄

- 邓小平

- 林彪

- 刘少奇

- 中共

- 皇帝

- 诸葛亮

- 易经

- 幽默人生

- 智慧

- 感悟

- 手机

- 预言

- 奇闻

- UFO

- 外星人

- 寿命

- 文革

- 养生

- 紫凤

- 贯明

- 李道真

- 轶飞

- 李云飞

- 云中君

- 辛思

- 夏闻

- 时代漫谈

- 沧海

- 东方纵横

- 唐柏桥

- 王尚一

- 江枫

- 黄清

- 李唐风

- 园丁

- 今涛拍暗

- 李青城

- 秦就石

- 中经研

- 秦天靖

- 江浩

- Eagle Vision

- 李子壬

- 马新宇

- 马来启

- 紫君

- 秦山

- 陈破空

- 戴东尼

- 曹长青

- 邢仁涛

- 瑜正

- 简易

- 肖川

- 伍凡

- 顾言

- 归瑜

- 乙欣

- 陈泱潮

- 徐沛

- 荷兰的蒙娜丽莎:〈戴珍珠耳环的少女〉(图)

- 江湖越老 胆子越小(图)

- 越来越贵的李宁终于跌落神坛(图)

- 朝俄联防外派工人逃离 手机成金正恩克星(图)

- “中国第一贪”江绵恒 如何被Google检索吓到了?(组图)